La Era de los Transistores, y del reemplazo parcial y completo de los añejos tubos de vacío: 2da Generación de Máquinas

Adentrémonos a nuestro tema principal. La Segunda Generación empieza en 1952 con los transistores, y termina en 1964 con el advenimiento de los circuitos integrados.

Al sustituirse parcialmente las válvulas de vacío por el transistor, comenzó la Segunda Generación de Computadoras. En ella las máquinas ganaron potencia y fiabilidad, perdiendo tamaño,

consumo y precio, lo que las hacía mucho más prácticas y asequibles. Los campos de aplicación de aquella época fueron, además de científico y militar, el administrativo y de gestión; es decir, las computadoras empezaron a utilizarse en las empresas que se dedicaban a los negocios. Comenzaron además a crearse los lenguajes de programación evolucionados, que hacían más sencilla la programación evolucionados; entre ellos podremos citar al Ensamblador y algunos de los denominados de alto nivel, como Fortrán, Cobol y Algol. (FORTRÁN Y COBOL YA FUERON MENCIONADOS EN EL ARTÍCULO QUE HABLA SOBRE LA TERCERA GENERACIÓN, pero esto no se debe a un craso error de mi autoría (o a una anacronía), sino a que impongo el criterio de que la mayoría de los lenguajes creados en la segunda generación de máquinas fueron desarrollados y expandidas durante la tercera).

consumo y precio, lo que las hacía mucho más prácticas y asequibles. Los campos de aplicación de aquella época fueron, además de científico y militar, el administrativo y de gestión; es decir, las computadoras empezaron a utilizarse en las empresas que se dedicaban a los negocios. Comenzaron además a crearse los lenguajes de programación evolucionados, que hacían más sencilla la programación evolucionados; entre ellos podremos citar al Ensamblador y algunos de los denominados de alto nivel, como Fortrán, Cobol y Algol. (FORTRÁN Y COBOL YA FUERON MENCIONADOS EN EL ARTÍCULO QUE HABLA SOBRE LA TERCERA GENERACIÓN, pero esto no se debe a un craso error de mi autoría (o a una anacronía), sino a que impongo el criterio de que la mayoría de los lenguajes creados en la segunda generación de máquinas fueron desarrollados y expandidas durante la tercera).

Asimismo, comenzaron a utilizarse como memoria interna los núcleos de ferrita y el tambor magnético, y como memoria externa la cinta magnética y los tambores magnéticos.

Así como en el artículo anterior, definiremos los siguientes nuevos términos: UNIVAC I, IBM 701, IBM 650, etc. (éstas fueron las máquinas imprescindibles de la época)

Transistores, núcleos de ferrita y tambores electromagnéticos (éstos fueron los principales hitos tecnológicos que inauguraron la segunda generación)

Transistores: elementos claves de aquella época, pues fueron los invencibles competidores que destronaron a las válvulas de vacío:

El transistor bipolar fue inventado en los Laboratorios Bell de EE. UU. en diciembre de 1947 por John Bardeen, Walter Houser Brattain y William Bradford Shockley, quienes fueron galardonados con el Premio Nobel de Física en 1956. Fue el sustituto de la válvula termoiónica de tres electrodos, o triodo.

La denominación "transistor" fue sugerida por J.R. Pierce, quién dijo: "…y entonces, en aquella época, el transistor fue imaginado para ser el dual del tubo de vacío, así si un tubo de vacío tenía transconductancia, éste debe tener transresistencia, y así llegué a sugerir «transistor»".

El transistor es un dispositivo electrónico semiconductor que cumple funciones de amplificador, oscilador, conmutador o rectificador-¡¡¡prestar suma atención a estos términos, pues en ellos está la clave que los convirtió en victoriosos indiscutibles!!!- El vocablo «transistor» es una contracción tomada del inglés, viene del término "transfer resistor" (resistencia de transferencia).

El transistor surge en los Laboratorios Bell de la AT&T. Se buscaba un conmutador de estado sólido para ser utilizado en telefonía y para reemplazar tanto a los relés como a los sistemas de barras, mas luego se contempló la posibilidad de obtener el reemplazo de la válvula (o tubo) de vacío.

¡¡¡ALTO!!! Lea atentamente los siguientes conceptos, pues son éstos los que describen las características principales de los transistores, y ayudan a deducir el porqué que los propulsó sobre las válvulas de vació.

El transistor cumplía funciones de:

*Amplificador Electrónico: incrementaba la intensidad de corriente y/o la tensión. Con ello obtenía como resultado un incremento potencial de la señal que se le aplica a su entrada, obteniéndose la señal aumentada a la salida (En las antenas). Para amplificar la potencia es necesario obtener la energía de una fuente de alimentación externa. En este sentido, se puede considerar a un amplificador, como un modulador de la salida de la fuente de alimentación.

*Oscilador: era capaz de convertir la corriente continua en una corriente periódica (hacía "oscilar la corriente"); estas oscilaciones pueden ser senoidales, cuadradas, triangulares, etc., dependiendo de la forma que tenga la onda producida. Un oscilador de onda cuadrada suele denominarse multivibrador y por lo tanto, se les llama osciladores sólo a los que funcionan en base al principio de oscilación natural que constituyen una "bobina L (inductancia)" y un condensador "C (Capacitancia)", mientras que a los demás se le asignan nombres especiales.

-Inductancia: es una medida de la oposición a un cambio de corriente de un inductor o bobina que almacena energía en presencia de un campo magnético, y se define como la relación entre el flujo magnético ( ) y la intensidad de corriente eléctrica (

) y la intensidad de corriente eléctrica ( ) que circula por la bobina y el número de vueltas (N) del devanado (vueltas del embobinado de un transformador)

) que circula por la bobina y el número de vueltas (N) del devanado (vueltas del embobinado de un transformador)

) y la intensidad de corriente eléctrica (

) y la intensidad de corriente eléctrica ( ) que circula por la bobina y el número de vueltas (N) del devanado (vueltas del embobinado de un transformador)

) que circula por la bobina y el número de vueltas (N) del devanado (vueltas del embobinado de un transformador)

-Capacitancia: La capacitancia (o capacidad eléctrica) es la propiedad que tienen los cuerpos para mantener una carga eléctrica. La capacitancia también es una medida de la cantidad de energía eléctrica almacenada para un potencial eléctrico dado. El dispositivo más común que almacena energía de esta forma es el condensador. La relación entre la diferencia de potencial (o tensión) existente entre las placas del condensador y la carga eléctrica almacenada en éste.

*Conmutador: permitía modificar el camino que deben seguir los electrones. Son típicos los utilizados por algunos componentes, como los relés. A la vez que desconectan un circuito, conectan otro.

*Rectificador: convertía la corriente alterna en corriente continua. Por lo general, esto realizaba utilizando diodos rectificadores, ya sean semiconductores de estado sólido, válvulas al vacío o válvulas gaseosas, como las de vapor de mercurio.

Los transistores se inauguraron con la modificación de la conductividad de algunos semiconductores, se tuvo en cuenta, para ello, a los saltos cuánticos, que dan lugar a distintos tipos de bandas energéticas, dependiendo de la distribución regular de los componentes. (Véase los espectros de emisión) http://es.scribd.com/doc/19622798/Espectro-de-emision-y-absorcion

El estudio del movimiento de los electrones en estas bandas, vislumbró la posibilidad de cambiar la conductividad eléctrica de algunos semiconductores, agregando impurezas controladas adecuadamente, surgiendo así los materiales de tipo N y de tipo P

¿Qué es un semiconductor tipo N?

Un semiconductor tipo N se obtiene llevando a cabo un proceso de "dopado" (aleación) añadiendo un cierto tipo de átomos al semiconductor para poder aumentar el número de portadores de carga libres (en este caso negativas o electrones).

¿Qué es un semiconductor tipo P?

Un semiconductor tipo P, también se obtiene llevando a cabo un proceso de "dopado" (aleación), añadiendo un cierto tipo de átomos al semiconductor para poder aumentar el número de portadores de cargas libres (en este caso positivos o huecos).

Un diodo surge al unir un material N con uno P, el transistor surge de una unión de tipo NPN, o bien PNP.

Ferrita: el material que se usó para las cintas de memoria de los ordenadores de la segunda generación

La 'ferrita' o hierro-α (alfa) es, en metalurgia, una de las estructuras cristalinas del hierro. Posee propiedades magnéticas y actualmente se emplea en la fabricación de imanes permanentes, aleados con cobalto y bario, en núcleos de inductancias y transformadores con níquel, zinc o manganeso, ya que en ellos quedan eliminadas prácticamente las Corrientes de Foucault (véase).

| Microestructura de la Ferrita |

Las ferritas son materiales cerámicos ferromagnéticos (sólo la alfa), compuestos por hierro, boro y bario, estroncio o molibdeno.Término genérico que define una gran variedad de materiales cerámicos ferromagnéticos. Todas las ferritas están compuestas por óxido de hierro y un metal. Las ferritas más simples de interés son las que tienen por fórmula química Fe2O3MO, donde M es un ion metálico divalente como el cobalto, níquel, cobre, cinc o hierro divalente.

Las ferritas tienen una alta permeabilidad magnética, lo cual les permite almacenar campos magnéticos con más fuerza que el hierro. Los primeros ordenadores estaban dotados de memorias que almacenaban sus datos en forma de campo magnético en núcleos de ferrita, los cuales estaban ensamblados en conjuntos de núcleos de memoria.

El polvo de ferrita se usa también en la fabricación de cintas para grabación; en este caso, el material es trióxido de hierro. Otra utilización común de los núcleos de ferrita es su uso en multitud de cables electrónicos para minimizar las interferencias electromagnéticas (EMI).

La Memoria Tambor: una forma primigenia de

memoria para los ordenadores

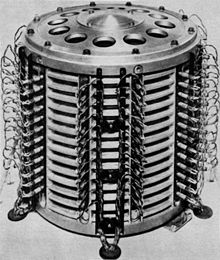

La Memoria de tambor fue una de las primeras memorias de ordenador. Inventada por Gustav Tauschek en Austria en 1932, fue ampliamente usada en los años 1950 y en los años 1960.

Para muchas máquinas, un tambor constituía la memoria de trabajo principal, siendo los datos y programas cargados o expedidos desde el tambor mediante cintas perforadas o tarjetas perforadas. Los tambores eran usados como memoria principal, razón por la que se hacía referencia a las máquinas como máquinas de tambor. Los tambores fueron posteriormente sustituidos por memorias de anillos de ferrita, más rápidas y sin partes móviles. Ésta última siguió siendo utilizada hasta que la memoria basada en semiconductores entró en escena.

El tambor era fijo, por lo que quedaba permanentemente montado en el dispositivo (no se lo reemplazaba).

Un tambor es un gran cilindro metálico cuya superficie exterior está recubierta por un material ferromagnético. Dicho en términos simples, se trata de un plato de disco duro (disco magnético) que tiene forma de tambor en lugar de tener forma de disco delgado. A lo largo del eje del tambor se dispone una fila de cabezas de lectura-escritura, una por cada pista.

La superficie del tambor magnético se podía magnetizar debido al material que lo rodeaba. El tambor giraba y sobre su superficie existían numerosas cabezas de lectura y escritura. Se almacenaban los datos en pistas paralelas sobre la superficie del tambor. Al girar el tambor la información almacenada pasaba por debajo de los cabezales de lectura/escritura.

Un tambor magnético se diferencia de un disco magnético en que las pistas en las cuales los datos son almacenados, son asignadas a canales localizados alrededor de la circunferencia del tambor. Es decir, los canales forman cintas circulares alrededor del tambor. Las funciones básicas de las cabezas de lectura/escritura son colocar puntos magnetizados (0's y 1's binarios) en el tambor durante una operación de la escritura y detectar estos puntos durante una operación de lectura. La función de leer y escribir de un tambor magnético funciona de una manera similar a las de una unidad de cinta magnética o una unidad de disco.

Para tener una idea de la velocidad y capacidad de almacenaje, algunos tambores de alta velocidad son capaces de transferir más de un millón de caracteres de datos por segundo, que es aproximadamente el equivalente a la lectura de un montón de tarjetas perforadas. Las capacidades de almacenaje de tambores magnético varían entre 20 millones y más de 150.000 millones de caracteres de datos.

La Memoria de Toros, o de Núcleos Magnéticos: toda una "tauromaquia" que reemplazó a los Tambores Magnéticos

La memoria de toros o memoria de núcleos magnéticos, fue una forma de memoria principal de los computadores, hasta comienzos de 1970. La función de esta memoria era similar a la que realiza la memoria RAM en la actualidad: es el espacio de trabajo, para la CPU, donde se graban los resultados inmediatos de las operaciones que se van realizando. A diferencia de la RAM basada en tecnologías DRAM, se basa en las propiedades magnéticas de su componente activo, el núcleo de ferrita y era una memoria no volátil.

*DRAM: tecnología actual de acceso aleatorio. Actualmente vigente en nuestras máquinas.

Tras desplazar a otras tecnologías de almacenamiento, la memoria de toros dominó la industria informática durante los años 50 y 60. Fue usada de manera extensa en computadoras y otros dispositivos electrónicos como las calculadoras. Intel fue creada con la idea de convertir la memoria de estado sólido en la memoria dominante en la industria de los computadores.

No pongo más, porque no quiero complicarles la existencia, pero les recomiendo mayor profundización.

IBM 701 "La Calculadora de Defensa"

|

| Tubo de Williams |

IBM 701, conocido como la "calculadora de Defensa" mientras era desarrollada, fue anunciada al público el 29 de abril de 1952 y era la primera computadora científica comercial de IBM. Sus hermanos en la computación de oficina eran el IBM 702 y el IBM 650. Durante los cuatro años de producción se vendieron 20 unidades.

El sistema utilizó tubos Williams para la memoria, consistiendo en 72 tubos con una capacidad de 1024 bits, dando una memoria total de 2048 palabras de 36 bits cada uno. Cada uno de los 72 tubos eran de 76 mm de diámetro.

*"El tubo Williams o tubo Williams-Kilburn (inventado por Freddie Williams y Tom Kilburn), desarrollado alrededor de 1946 o 1947, era un tubo de rayos catódicos usado para almacenar electrónicamente datos binarios."

La memoria se podía ampliar a un máximo de 4096 palabras de 36 bits por la adición de un segundo sistema de 72 tubos o substituyendo la memoria entera por memoria de núcleos magnéticos. El tiempo de acceso de la memoria de tubos y de la de núcleo de ferrita era de 12 microsegundos. La memoria de tubos necesitaba "refrescarse" periódicamente. Una operación entera de suma tomaba 5 ciclos de máquina con 12 microsegundos (60 microsegundos), también multiplicaba y dividía en 38 ciclos de la máquina con 12 microsegundos (456 microsegundos).

IBM 650: "Una Máquina que usaba Código Biquinario"

El primero que fue fabricado a gran escala. Fue anunciado en 1953, y se produjeron 2000 unidades desde 1954 (la primera venta) hasta 1962. En 1969, IBM dejó de dar servicio técnico para dicha máquina y sus componentes.

El IBM 650 es una máquina que codifica tantos datos como direcciones de memoria en sistema decimal, guardando cada cifra en código biquinario. Este código guarda, mediante varios bits, dos variables: una con 2 posibles estados, y otra con 5 posibles estados.

El código biquinario es un sistema de numeración usado en ábacos y en algunos de los primeros ordenadores, como el Colossus. El término biquinario se refiere a que el código tiene una parte de dos estados (bi) y otra de cinco estados (quin).

Existen varias representaciones de un decimal codificado en biquinario, ya que el componente de dos estados se puede representar tanto con uno, como con dos bits; y puesto que el componente de cinco estados puede ser representado, tanto con dos, como con cinco bits.

El IBM 650 tenía 7 bits: dos para la componente binaria (pesos 0, 5) y cinco para la componente quinaria (pesos 0, 1, 2, 3, 4). En la foto de abajo se pueden observar estos indicadores:

Valor Bits 05-01234 0 10-10000 1 10-01000 2 10-00100 3 10-00010 4 10-00001 5 01-10000 6 01-01000 7 01-00100 8 01-00010 9 01-00001

Lenguaje Ensamblador, un lenguaje de bajo nivel.

El lenguaje ensamblador, o assembler (assembly language en inglés) es un lenguaje de programación de bajo nivel para los computadores, microprocesadores, microcontroladores, y otros circuitos integrados programables. Implementa una representación simbólica de los códigos de máquina binarios y otras constantes necesarias para programar una arquitectura dada de CPU y constituye la representación más directa del código máquina específico para cada arquitectura legible por un programador.

Esta representación es usualmente definida por el fabricante de hardware, y está basada en los mnemónicos que simbolizan los pasos de procesamiento (las instrucciones), los registros del procesador, las posiciones de memoria, y otras características del lenguaje. Un lenguaje ensamblador es por lo tanto específico a cierta arquitectura de computador física (o virtual). Esto está en contraste con la mayoría de los lenguajes de programación de alto nivel, que idealmente son portables.

Un programa útil, llamado Ensamblador, es usado para traducir sentencias del lenguaje ensamblador al código de máquina del computador objetivo. El Ensamblador realiza una traducción más o menos isomorfa (un mapeo de uno a uno) desde las sentencias mnemónicas a las instrucciones y datos de máquina. Esto está en contraste con los lenguajes de alto nivel, en los cuales una sola declaración generalmente da lugar a muchas instrucciones de máquina.

Fue usado principalmente en los inicios del desarrollo de software, cuando aún no se contaba con potentes lenguajes de alto nivel y los recursos eran limitados. Actualmente se utiliza con frecuencia en ambientes académicos y de investigación, especialmente cuando se requiere la manipulación directa de hardware, altos rendimientos, o un uso de recursos controlado y reducido.

Muchos dispositivos programables (como los microcontroladores) aún cuentan con el ensamblador como la única manera de ser manipulados.

Lenguaje ALGOL (El que precesió al lenguaje Pascal, C y Ada)

Se denomina ALGOL (o Algol) a un lenguaje de programación. La voz es un acrónimo de las palabras inglesas Algorithmic Language (lenguaje algorítmico).

Fue muy popular en las universidades durante los años 60, pero no llegó a cuajar como lenguaje de utilización comercial.

Sin embargo, Algol influyó profundamente en varios lenguajes posteriores que sí alcanzaron gran difusión, como Pascal, C y Ada.

Hacia 1965 dos corrientes se distinguieron sobre el tema de un sucesor para Algol. Como resultado se definieron los lenguajes Algol W que es un lenguaje minimalista, rápidamente implementado y distribuido y, por otra parte, Algol 68 que para la época está en la frontera entre un lenguaje para programar en él y un lenguaje para investigar sobre él.

Penúltimo Escalón Generacional: Primera Generación de Computadoras.

Empieza en 1940, y termina en 1952. La constituyen todas aquellas computadoras diseñadas a base de válvulas de vacío, como principal elemento de control y cuyo uso fundamental fue la realización de aplicaciones en campos científicos y militar. Utilizaban el lenguaje máquina, como lenguaje de programación. Las tarjetas y cintas perforadoras, junto con las líneas de demora de mercurio.

Antecedentes Directos: Entre 1937 y 1942, un profesores de Iowa Satate University, John V. Atanasoff, y un estudiante graduado, Clifford E. Berry, trabajaron en un prototipo para una computadora electrónica. La computadora de Atanasoff-Berry (ABC) fue la primera en emplear los tubos de vacío en lugar de interruptores mecánicos, para los circuitos de procesamiento. Su diseño también incorporó la idea de basar los cálculos en el sistema de números binarios. La ABC suele ser considerada la primera computadora digital electrónica. Según un historiador, "Lo primero que mostró ABC en 1939 es que tal vez no tenía mucho de computadora, igual que el modelo de los hermanos Wright no tenía mucho de aeroplano, pero abrió el camino". Anteriormente dije que solía ser considerada como la primera "computadora digital electrónica", pero esto es discutible, puesto que también se alega que no puede ser considerada computadora, ya que no era programable, por lo cual se prefiere la denominación de "Calculadora Digital".

Mientras Atanasoff trabajaba en la ABC, un ingeniero alemán llamado Konrad Zuse desarrolló una computadora llamada Z3, la cual, igual que la ABC, fue diseñada para trabajar con números binarios. Construída en Alemania nazi, durante la Segunda Guerra Mundial, la máquina fue mantenida en secreto, aún cuando Hitler creía que las computadoras no tenían un uso estratégico en la guerra. La información sobre el inventor de "Zuse" (la computadora) no surgió mucho después que terminó la guerra. De modo que aunque Zuse fue uno de los pioneros de la arquitectura de las computadoras modernas, su trabajo tuvo poco efecto en el desarrollo de las mismas.

En 1937 Howard H. Aiken (1900-1973), de la Universidad de Harvard, desarrolla la idea de Babbage, junto con un equipo de científicos de su departamento, y de ingenieros de IBM. El resultado de sus estudios culminó en la construcción de una calculadora numérica basada en el uso de relés electromagnéticos Fue denominada la Calculadora Automática de Secuencia Controlada (ASCC, por sus siglas en inglés) aunque su nombre más popular fue la Harvard Mark-I.

Esta computadora fue ideada para 1937, pero se terminó de construir en 1944 y tenía elementos de entrada, memoria central, unidad aritmética, unidad de control y elementos de salida. Utilizaba como soportes de entrada de datos tarjetas y cintas perforadoras.

Esta máquina fue la primera computadora electromagnética (prestar atención a los términos) que se construyó y que funcionó, aunque se utilizó poco tiempo, pues la aparición de computadoras electrónicas (ojo con los términos) hizo que las de este tipo cayeran rápidamente en desuso.

Tenía 16,6 metros de largo por 2,6 metros de alto, pesaba unas 70 toneladas y estaba constituida por 800.000 piezas móviles, teniendo su cableado una longitud de 800.000 metros.

Sumaba dos números en menos de un segundo y los multiplicaba en tres segundos, dando las respuestas en tarjetas perforadas. Trabajaba con operadores de hasta 23 cifras decimales. Estaba preparada para el cálculo de tablas matemáticas y su velocidad era mucho mayor que la de las calculadoras de la época.

En 1938, el alemán Claude Shannon comenzó a aplicar la teoría del álgebra de Boole (prestar atención) en la representación de circuitos lógicos. Publicó en 1948 la teoría matemática de las comunicaciones y relizó diversos estudios sobre la teoría de la información (Ojo), donde aparecieron medidas de cantidad de información, como el bit (binary digit)

También en 1938, el físico norteamericano John Vicent Atanasoff, profesor de la Universidad de Iowa, junto con su colaborador Clifford Berry construyeron una máquina electrónica que operaba en binario siguiendo la idea de Babbage. Fueron los primeros que intentaron la construcción de una máquina totalmente electrónica. Ésta fue terminada en 1942 y se llamó ABC (Atanasoff Berry Computer) siendo considerada como la primera máquina de calcular digital. No tomó carácter de computadora puesto que no existía la posibilidad de programarla. Se utilizó fundamentalmente para la resolución de ecuaciones lineales y diferenciales.

Entraremos a la primera generación de máquinas con las siguientes definiciones: válvulas de vacío, relés electromagnéticos, Eniac y Edvac. Diferencias entre computadoras electrónicas, y electromagnéticas, teoría de álgebra de Boole, teoría de la información y diferencias entre computadoras digitales y analógicas.

*Válvulas de Vacío:

La válvula electrónica, también llamada válvula termoiónica, válvula de vacío, tubo de vacío o bulbo, es un componente electrónico utilizado para amplificar, conmutar, o modificar una señal eléctrica mediante el control del movimiento de los electrones en un espacio "vacío" a muy baja presión, o en presencia de gases especialmente seleccionados. La válvula originaria fue el componente crítico que posibilitó el desarrollo de la electrónica durante la primera mitad del siglo XX, incluyendo la expansión y comercialización de la radiodifusión, televisión, radar, audio, redes telefónicas, computadoras analógicas y digitales, control industrial, etc. Algunas de estas aplicaciones son anteriores a la válvula, pero vivieron un crecimiento explosivo gracias a ella.

A lo largo de su historia, fueron introducidos muchísimos tipos de válvulas, pero los principios de funcionamiento básicos son:

El Efecto Edison: La gran mayoría de las válvulas electrónicas están basadas en la propiedad que tienen los metales calientes de liberar electrones desde su superficie.

Los Gases ionizados: En otros casos, se utilizan las características de la conducción electrónica en gases ionizados, esto resulta principalmente importante en los reguladores de tensión, rectificadores de vapor de mercurio, válvula de conmutación T/R, etc.

El Efecto fotoeléctrico: En otros casos, el principio de funcionamiento se basa en la emisión de electrones por el efecto fotoeléctrico, cuando sobre éste se hace incidir luz eléctrica (luz visible y ultravioleta en general)

El efecto de emisión termoiónica fue originalmente reportado por Frederick Guthrie en 1873, pero es la investigación de Thomas Alva Edison el trabajo más a menudo mencionado. Edison, al ver que con el uso el cristal de las lámparas incandescentes se iba oscureciendo, buscó la forma de aminorar dicho efecto, realizando para ello diversos experimentos. Uno de ellos fue la introducción en la ampolla de la lámpara de un electrodo en forma de placa, que se polarizaba eléctricamente con el fin de atraer las partículas que, al parecer, se desprendían del filamento. A pesar de que Edison no comprendía a nivel físico el funcionamiento, y desconocía el potencial de su"descubrimiento", en 1884 Edison lo patentó bajo el nombre de "Efecto Edison".

Al agregar un electrodo plano (placa), cuando el filamento se calienta, se produce una agitación de los átomos del material que lo recubre, y los electrones de las órbitas de valencia (los de la última capa) son acelerados, alcanzando velocidades de escape, con lo que se forma una nube de electrones por encima del mismo. La nube termoiónica, fuertemente atraída por la placa, debido al potencial positivo aplicado en la misma, da lugar a la circulación de una corriente electrónica a través de la válvula entre el filamento y el ánodo. A este fenómeno se le denomina Efecto Edison-Richardson o termoiónico.

Llegados a este punto, tenemos que la válvula termoiónica más simple está constituida por una ampolla de vidrio, similar a la de las lámparas de incandescencia, a la que se le ha practicado el vacío y en la que se hallan encerrados dos electrodos, denominados cátodo y ánodo.

El cátodo consiste en un filamento de wolframio, recubierto por una sustancia rica en electrones libres, que se calienta mediante el paso de una corriente. El ánodo está formado por una placa metálica que rodea al filamento a una cierta distancia y a la que se aplica un potencial positivo. Por constar de dos electrodos a la válvula antes descrita se le denomina diodo. Existen variantes más complejas, como los triodos, tetrodos, y pentodos, los cuales no explicaremos en este artículo, y posiblemente tampoco en los siguientes, por el momento. Pero... no me abstendré de proveerles del material necesario, para quienes son aficionados de la investigación, y de la autodicción.Empieza en 1940, y termina en 1952. La constituyen todas aquellas computadoras diseñadas a base de válvulas de vacío, como principal elemento de control y cuyo uso fundamental fue la realización de aplicaciones en campos científicos y militar. Utilizaban el lenguaje máquina, como lenguaje de programación. Las tarjetas y cintas perforadoras, junto con las líneas de demora de mercurio.

Antecedentes Directos: Entre 1937 y 1942, un profesores de Iowa Satate University, John V. Atanasoff, y un estudiante graduado, Clifford E. Berry, trabajaron en un prototipo para una computadora electrónica. La computadora de Atanasoff-Berry (ABC) fue la primera en emplear los tubos de vacío en lugar de interruptores mecánicos, para los circuitos de procesamiento. Su diseño también incorporó la idea de basar los cálculos en el sistema de números binarios. La ABC suele ser considerada la primera computadora digital electrónica. Según un historiador, "Lo primero que mostró ABC en 1939 es que tal vez no tenía mucho de computadora, igual que el modelo de los hermanos Wright no tenía mucho de aeroplano, pero abrió el camino". Anteriormente dije que solía ser considerada como la primera "computadora digital electrónica", pero esto es discutible, puesto que también se alega que no puede ser considerada computadora, ya que no era programable, por lo cual se prefiere la denominación de "Calculadora Digital".

Mientras Atanasoff trabajaba en la ABC, un ingeniero alemán llamado Konrad Zuse desarrolló una computadora llamada Z3, la cual, igual que la ABC, fue diseñada para trabajar con números binarios. Construída en Alemania nazi, durante la Segunda Guerra Mundial, la máquina fue mantenida en secreto, aún cuando Hitler creía que las computadoras no tenían un uso estratégico en la guerra. La información sobre el inventor de "Zuse" (la computadora) no surgió mucho después que terminó la guerra. De modo que aunque Zuse fue uno de los pioneros de la arquitectura de las computadoras modernas, su trabajo tuvo poco efecto en el desarrollo de las mismas.

En 1937 Howard H. Aiken (1900-1973), de la Universidad de Harvard, desarrolla la idea de Babbage, junto con un equipo de científicos de su departamento, y de ingenieros de IBM. El resultado de sus estudios culminó en la construcción de una calculadora numérica basada en el uso de relés electromagnéticos Fue denominada la Calculadora Automática de Secuencia Controlada (ASCC, por sus siglas en inglés) aunque su nombre más popular fue la Harvard Mark-I.

Esta computadora fue ideada para 1937, pero se terminó de construir en 1944 y tenía elementos de entrada, memoria central, unidad aritmética, unidad de control y elementos de salida. Utilizaba como soportes de entrada de datos tarjetas y cintas perforadoras.

Esta máquina fue la primera computadora electromagnética (prestar atención a los términos) que se construyó y que funcionó, aunque se utilizó poco tiempo, pues la aparición de computadoras electrónicas (ojo con los términos) hizo que las de este tipo cayeran rápidamente en desuso.

Tenía 16,6 metros de largo por 2,6 metros de alto, pesaba unas 70 toneladas y estaba constituida por 800.000 piezas móviles, teniendo su cableado una longitud de 800.000 metros.

Sumaba dos números en menos de un segundo y los multiplicaba en tres segundos, dando las respuestas en tarjetas perforadas. Trabajaba con operadores de hasta 23 cifras decimales. Estaba preparada para el cálculo de tablas matemáticas y su velocidad era mucho mayor que la de las calculadoras de la época.

En 1938, el alemán Claude Shannon comenzó a aplicar la teoría del álgebra de Boole (prestar atención) en la representación de circuitos lógicos. Publicó en 1948 la teoría matemática de las comunicaciones y relizó diversos estudios sobre la teoría de la información (Ojo), donde aparecieron medidas de cantidad de información, como el bit (binary digit)

También en 1938, el físico norteamericano John Vicent Atanasoff, profesor de la Universidad de Iowa, junto con su colaborador Clifford Berry construyeron una máquina electrónica que operaba en binario siguiendo la idea de Babbage. Fueron los primeros que intentaron la construcción de una máquina totalmente electrónica. Ésta fue terminada en 1942 y se llamó ABC (Atanasoff Berry Computer) siendo considerada como la primera máquina de calcular digital. No tomó carácter de computadora puesto que no existía la posibilidad de programarla. Se utilizó fundamentalmente para la resolución de ecuaciones lineales y diferenciales.

Entraremos a la primera generación de máquinas con las siguientes definiciones: válvulas de vacío, relés electromagnéticos, Eniac y Edvac. Diferencias entre computadoras electrónicas, y electromagnéticas, teoría de álgebra de Boole, teoría de la información y diferencias entre computadoras digitales y analógicas.

*Válvulas de Vacío:

La válvula electrónica, también llamada válvula termoiónica, válvula de vacío, tubo de vacío o bulbo, es un componente electrónico utilizado para amplificar, conmutar, o modificar una señal eléctrica mediante el control del movimiento de los electrones en un espacio "vacío" a muy baja presión, o en presencia de gases especialmente seleccionados. La válvula originaria fue el componente crítico que posibilitó el desarrollo de la electrónica durante la primera mitad del siglo XX, incluyendo la expansión y comercialización de la radiodifusión, televisión, radar, audio, redes telefónicas, computadoras analógicas y digitales, control industrial, etc. Algunas de estas aplicaciones son anteriores a la válvula, pero vivieron un crecimiento explosivo gracias a ella.

A lo largo de su historia, fueron introducidos muchísimos tipos de válvulas, pero los principios de funcionamiento básicos son:

El Efecto Edison: La gran mayoría de las válvulas electrónicas están basadas en la propiedad que tienen los metales calientes de liberar electrones desde su superficie.

Los Gases ionizados: En otros casos, se utilizan las características de la conducción electrónica en gases ionizados, esto resulta principalmente importante en los reguladores de tensión, rectificadores de vapor de mercurio, válvula de conmutación T/R, etc.

El Efecto fotoeléctrico: En otros casos, el principio de funcionamiento se basa en la emisión de electrones por el efecto fotoeléctrico, cuando sobre éste se hace incidir luz eléctrica (luz visible y ultravioleta en general)

El efecto de emisión termoiónica fue originalmente reportado por Frederick Guthrie en 1873, pero es la investigación de Thomas Alva Edison el trabajo más a menudo mencionado. Edison, al ver que con el uso el cristal de las lámparas incandescentes se iba oscureciendo, buscó la forma de aminorar dicho efecto, realizando para ello diversos experimentos. Uno de ellos fue la introducción en la ampolla de la lámpara de un electrodo en forma de placa, que se polarizaba eléctricamente con el fin de atraer las partículas que, al parecer, se desprendían del filamento. A pesar de que Edison no comprendía a nivel físico el funcionamiento, y desconocía el potencial de su"descubrimiento", en 1884 Edison lo patentó bajo el nombre de "Efecto Edison".

Al agregar un electrodo plano (placa), cuando el filamento se calienta, se produce una agitación de los átomos del material que lo recubre, y los electrones de las órbitas de valencia (los de la última capa) son acelerados, alcanzando velocidades de escape, con lo que se forma una nube de electrones por encima del mismo. La nube termoiónica, fuertemente atraída por la placa, debido al potencial positivo aplicado en la misma, da lugar a la circulación de una corriente electrónica a través de la válvula entre el filamento y el ánodo. A este fenómeno se le denomina Efecto Edison-Richardson o termoiónico.

Llegados a este punto, tenemos que la válvula termoiónica más simple está constituida por una ampolla de vidrio, similar a la de las lámparas de incandescencia, a la que se le ha practicado el vacío y en la que se hallan encerrados dos electrodos, denominados cátodo y ánodo.

- http://personales.unican.es/perezvr/pdf/Amplificadores%20de%20RF%20de%20Potencia%20Final.pdf

- http://www.vudusa.com.ar/files/books/Transmision_RCA_hasta_4_KW.pdf

- http://www.gsbroadcast.com.ar/VALVULAS%20DE%20POTENCIA.pdf

¿Y PARA QUÉ SERVÍAN SEMEJANTES COMPONENTES?

Se utilizaban para guardar bits de datos individuales. Cuando el tubo de vacío controla el flujo de electrones en el "vacío" cada tubo representaría un estado (ya sea de encendido o de apagado) esto pasaría a representar el código binario, por lo que a determinados estados (los cuales son sólo dos) se les asigna los valores 0 y 1. Los tubos eran una "ventaja" frente a los relevadores mecánicos, ya que generaban cálculos más veloces. Sin embargo, tras las presumibles ventajas, estaban también las desventajas que los desterraron al olvido, en el campo de la informática. Consumían demasiada electricidad, y gran parte de ella se perdía como calor. Había que renovarlos en varias ocasiones, puesto que eran muy poco duraderas, y se quemaban con suma rapidez. La Eniac, un prototipo que representaría el inicio de la primera generación (por lo cual hablaremos de la misma detalladamente) contenía 18.000 tubos, y cada uno fue reemplazado, cuanto menos, alrededor de una vez en la duración de su primer año de funcionamiento.

Estas descripciones son aterradoras, pero no tanto como presumir o imaginar los costos que debió haber arrastrado su uso, puesto que si bien la adquisición de las computadoras era sumamente cara, también lo era su mantenimiento. No sorprendería saber cuán desgastadas han de haber estado las billeteras y las arcas de sus adquisidores, pues palpablemente, los costos acarreados fueron en lo sumo ingentes.

Precisamente donde se hacía todos los cálculos algorítmicos, era donde había más problemas y derroche de dinero: en los tubos de vacío.

El centro de procesamiento de datos estaba intrínsecamente protagonizado por estos bulbos, y eran la memoria principal en la primera generación.

Sin embargo, los tubos de vacío hicieron posible una programación aún más acelerada y flexible, para lo que se conocía en aquellos tiempos. Se crearon programas de aplicaciones personalizadas, hechos sobre pedido para una tarea específica. La programación de aquella época no era en nada parecida a la actual, salvo por los conceptos elementales y fundamentales. Los programadores no pudieron manejar otro lenguaje de programación, que el mismo lenguaje máquina: unos y ceros.

Absolutamente todas las instrucciones se escribieron en códigos binarios, donde 1+1=10 ¿Habrán conservado la compostura mental después de tan escrupulosa tarea? Conforme a la sucesión cronológica, se vino una progresión vital para nuestro presente: el desarrollo de los primeros compiladores (muy rudimentarios) los cuales permitieron escribir las instrucciones mediante lenguajes ensambladores.

El LDA, y el JNZ son claros ejemplos de los pequeños primeros pasos que se dieron hasta llegar a nuestro statu quo. Sin embargo, no todo fue dulce como la miel: existía un código binario con instrucciones específicas, para máquinas con hardwares específicos. Ninguno de los compiladores pudieron ser categorizados como universales.

Continuará

No hay comentarios:

Publicar un comentario

Añadir los comentarios libres aquí